はい、ごめんください。

クラリティが好きすぎて非公式エバンジェリストを名乗り始めたコスギです。

先日の2024年2月23・24日に開催された WordCamp Kansai 2024 で、「ユーザー行動の分析からサイトの改善ポイントを探ろう」というタイトルで登壇してきましたので、その振り返りと補足記事です。サブタイトルは「Microsoft Clarity なら、初心者もニッコリ☺」なのですが、とても便利なツールだからこそメリットとリスクはちゃんと知っておきましょうねという話。

スライドは以下です。動画ももう公開されています。はやっ!!(マイクが近くて声がデカイので音量注意)

文字ばかりのスライドなので補足

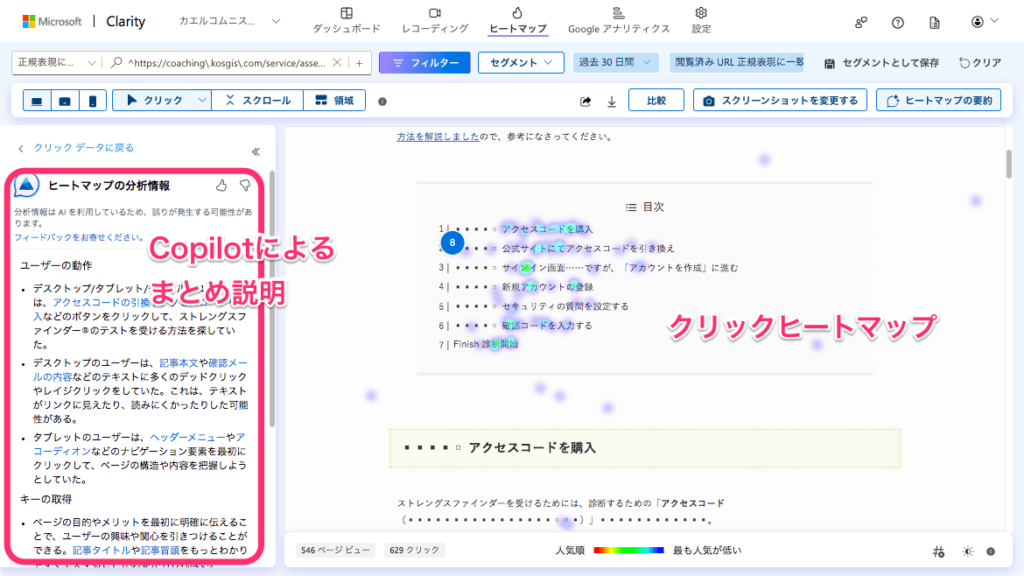

視覚的にわかりやすいヒートマップ

ブログやページに目次を入れることが一般的になりましたが、目次のどこがクリックされているのかなどもわかりますね。こういったヒートマップの全体像をAI(Copilot)がまとめてくれる機能もあります。

ただ個人的には、目的ありきの検証前提でツールを使っているので、Copilot のまとめを読んでも「まあ、それは見ればわかるんだけどさ」「改善施策はそっちじゃないんだよなあ……」という感想になることがほとんどなので、たまーにしか使いません。とはいえ人間の盲点があるので、参考にならないとまでは言わないです。

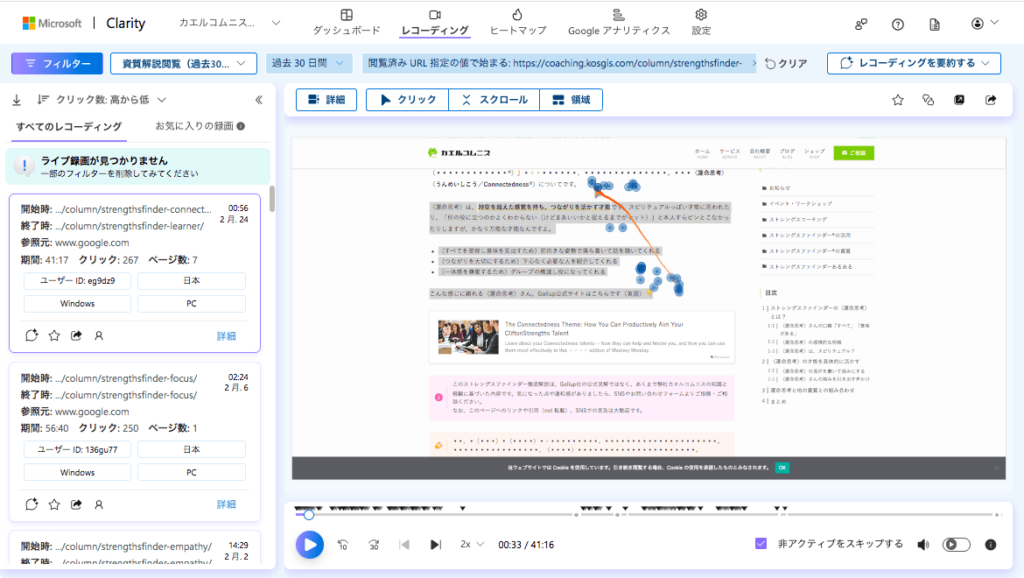

ユーザー行動を追体験できるレコーディング機能

個人情報を取得しない状態での録画機能です。録画は長さがまちまちなので、10分を超えるような場合は Copilot を使うことが多いです。右上の[レコーディングを要約する]から複数のセッションを選択することもできるので、ここは使いやすくなってきた印象です。

以下のようにクリック数でソートすると、とんでもない量のクリック数の録画が出てくることがありますが、動きを見ると「文章を選択したり画面をカチカチしながら読むクセのあるユーザー」ということがわかるのですよね。こういう方は Know クエリで入って来た後にじっくりと読み進めるため、熱量の高いユーザー(ファン)になりやすいです。

Microsoft Clarity のライブデモを見てみる

Microsoft Clarity の公式サイトに、[ライブデモを見る]ボタンがあるので、そこからすぐに確認できます。言語設定もできますが、英語でもそんなに難しくないですよ。日本語訳がビミョーで違和感が拭いきれなければ、英語で使うのもオススメです。「る」だけ改行しているとか、ちょっとね……

クエリの種類を調べてみる

ここは Know クエリと Buy クエリの話として、Google Search Console(サーチコンソール)を見ていただきたいところ。検索パフォーマンス → 検索結果の画面をスクロールすると、自分のサイトが検索結果としてどのように扱われているのかを確認できます。私は表示回数でソートし、クエリの検索順位とクリック数を確認しています。毎回確認するのがメンドクサイので Google Looker Studio(ルッカースタジオ)を使っているのですが。

実際に行った施策の検証事例

実際に解析をすると30分くらいタラタラタラタラ喋っちゃったので、1.5倍速にしました。余計に何を喋ってるかわからないと思うので、要所要所で飛ばしながら見ていただけたら。気力があったら改善後の解析に差し替えます。

そして「こうすれば回遊が上がりそうだな」と、登壇2日前(2月22日)に回遊動線のリンクを1ページのみ設定してみた結果。

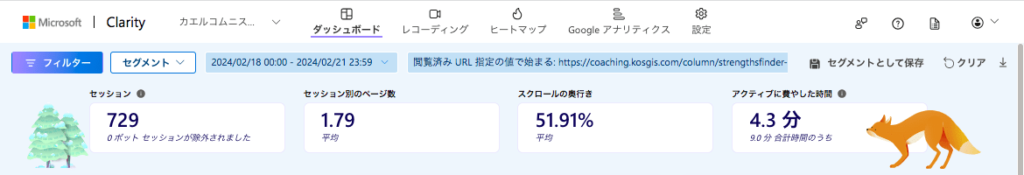

2023年2月18日〜21日(施策前4日間)のセッション別のページ数

直前の期間だけに絞ると、30日間の平均より値が高めだな……と一抹の不安を覚えつつ……

2023年2月22日〜24日(施策後4日間)のセッション別のページ数

減っとるやん/(^o^)\/(^o^)\/(^o^)\

脳内で盛大なツッコミをして、データがイイカンジになるところを見せたい衝動に駆られましたが、現実を受け止めることにします。とはいえ、セッション(=母数)が減ればそれ以外の指標の差異は大きくなりやすいので、定性的な情報も見てみましょう。

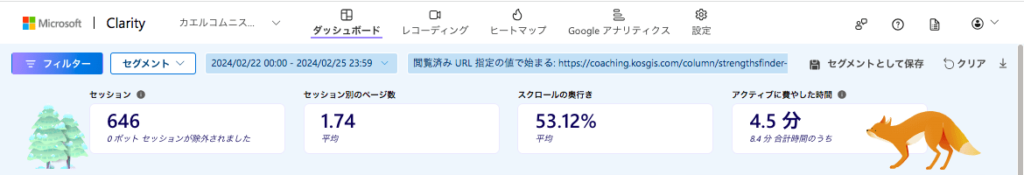

施策箇所をヒートマップで検証

ということで、設置したリンクがクリックされたかどうかを、クリックヒートマップで検証したところ……

1ページのみの施策でも行動としての動作を確認でき、その録画でも閲覧者自身に関わるページを閲覧する(当初想定していた)動作も確認できたので、この施策を全ページに展開してから再度検証を行うことにします。

そもそも4日間という誤差の大きい期間ということや、ページ下部でスクロールが必要な箇所の改善ということもあり、定量的には劇的に変化が見られるものではないと判断できるものの、定性的には効果がありそうと判断できるのが Microsoft Clarity のオモシロイところですね。だから大好きなんですよー

質疑応答の回答

登壇中にいただいたご質問をまとめました。たっぷり聞いてくれてええんやで。

①どれくらいのタイムスパンで解析を行えば良いですか?

身も蓋もない言い方ですが、解析頻度は目的によります。毎日変動する数値を見ていくなら、毎日見たほうが良いですよね。施策が月1回なら、施策してから毎日14日間、週間、月間で変化を見る、などになるかなって。

目標に達するまでは毎日〜3日に1回など確認することを継続したほうが良いのですが、毎回レポーティングしているとメンd……大変なので、Looker Studio などで定点観測できるようにしておくことをオススメします。ちなみに、私はほとんど文章の入ったレポートを作成しなくなりました。誰も読まないですから。

ココだけ見ておけばいいよね、というKPI(うまくいっているかどうかを判断するための重要な指標)をあらかじめ設定しておくほうがずっと大切です。重要な指標が上がらなければ原因を探って改善する、とかのほうが動きやすいんですよ。それを毎日見ておけば「あれ?上がってこないな……」と気づけるじゃないですか。

②異常値をどのように考えたら良いですか?(追記あり)

異常値のほとんどはスパムです。まずはその前提から考えます。

- 参照元が Direct などで不明? → ほぼスパム(クラリティで bot アクセスを確認)

- 参照元が知らない企業? → リファラースパムの可能性大(検索して調べてみる)

- 参照元が Social などのSNS? → Yes の場合はサイト外でバズっている

- 参照元がビジネスツール系? → 企業内部で話題になっている

ということで、ほとんどがbot(スパム)アクセスと判断できると思いましたが、後ほど詳しい話をお伺いできたので、考え方として重要なところだけ共有します。

ということで「異常値があっても実際に売れているから、どう考えたら良いのかわからない」というご質問でした。つまり「おそらくSNSでバズっているのに、再現性がなくもどかしい」という話。なにこのうれしい悲鳴。

これはダークソーシャルがらみですね。LINEグループなど、解析ツールでは把握できないSNS上のコミュニティがあります。そこで拡散されると、異常値になることがあります。今回はそのタイプだろうなって。「ダークソーシャル」で検索すると色々と出てきますが、参考までに以下をどうぞ。

それこそ、このタイミングで購入した方向けに、(スライドの4象限で示した)アンケートなどのユーザーインタビューを使って検証するのもオススメです。ただアンケートを送るのではなく、ダークソーシャル内の検証を考えたものにすれば、再現性も見えてくるのでは。業種によってはダークソーシャルでのシェアがかなり多いこともありますしね。

もちろん、なぜ「ダーク」なのかを想定した検証が大切です。彼らにとって心理的安心感のあるところに企業都合の光を照らすことは、ブランド毀損にもなりかねないので注意が必要です。

③個人情報を個別にマスクする方法はありますか?

あります!以下の記事の「あやしい箇所は手動でマスク設定しておく」から紹介しています。

逆に、マスクしない方法もあります。たとえば、「この記事、いつ更新したんだっけ?そうそう更新日を確認すれば……マスクされてるー!/(^o^)\」ってときに活用できます。タイトルなど、個人情報が関わらない箇所で更新が想定されるような場合は、マスクを解除しておくと分析しやすいですね。

ご参加いただいた方の声

ポストありがとうございましたー!!

実際の業務に取り入れたいなと思った時、導入してあるんだけどうすれば?と行き詰まった時に、いつでもお声がけください(/・ω・)/(ウェブのお仕事もちゃんとやっていますYO)

登壇にあたっての余談

WordCamp に登壇できるのは、審査があるためかなり貴重なのですが、このような機会をいただけてウレシかったです。そして何より、「やっぱり目的大事だよね」というフィードバックが多かったことに感動しました。今もじんわりと心があったかくなるくらい。

数年前に東京で登壇した際に「目的や戦略はいいから解析の手法が見たかった」というフィードバックをいくつかいただいたんです。それがずっと胸にチクチクと刺さり続けていて、「WordPress 界隈の方々、手段が目的化しているのはもったいないなあ……」「でも、求められるのは手法の方なんだろうなあ……」とモヤモヤした思いを抱えていたんですよね。またこのフィードバックが来るかと思うと、正直、怖かったんです。

それでも、Microsoft Clarity は個人情報が隣り合わせのツールでもあるため、私も自戒を重ねていたからこそ、今回はちゃんと伝えておかなければならないと考えました。これでも「目的は別にいらんから手法を詳しく」と言われたとしても「そんな状態でユーザー行動分析できるとお思いか?あなたはともかく、訪問者の個人情報に興味がないまま、今後やっていくおつもりか?」と前のめりのスタンスになりました。

これはスライド作成にあたって、リスクに関する記事を書けたことが大きいです。登壇は人を成長させますね。とはいえ、まだ私も十分理解していませんから、私より危機感がないのはマズイんじゃないかって。だから「Microsoft Clarity は便利で面白そうだけど怖い」という感覚を持っていただけたのなら、役割を果たせたかなと思います。

それと、私は「GA4は嫌い」を連呼しています。面倒くさいし、難しいし。世の中には必要性もわからずに「嫌いだから使いたくない」と言えない人のほうが多い印象なので、私のように「嫌い」って言えたらいいんじゃないかと思っていて。解析は役に立つけれど、戦略や目的がハッキリしておらず、検証の必要性がないなら解析ツールなんて不要なんですよ。訪問者の情報を持っているのなんて、リスクでしょ。

私は、必要だから使っています。定性分析するにしても、定量分析でわかることはたくさんありますし。ただ、極力触りたくないので Looker Studio を使っています。GA4を見る必要があるときは、得意な人に相談します。嫌いでも、やらなきゃならないときはやります。オトナなので。

あとは自分のサービスに関する事例を提供できるようになったことは、東京のときよりも大きく変わったなって。事例ですから、具体的なサービス内容はわからなくても、「自分たちだったら、ここをどう考えようかな」と思考プロセスから理解しやすくなったのではないかと思います。

動いているところをお見せできなかったのは心苦しいですが、公式サイトにはデモが用意されているので、興味がなくても触るだけ触ってみることをオススメします。嫌いでも、やらなきゃならないときはやらなきゃね。Microsoft Clarity の魅力に関しては一晩中語れるので、社内セミナーや勉強会があれば呼んでくだされ。